科技:分割一切!AI视觉领域奋起直追

文章来自微信公众号“科文路”,欢迎关注、互动。转发须注明出处。

自从 ChatGPT 横空出世,AI 的各个领域好像都被点燃了。

与自然语言处理同为热门的计算机视觉(Computer Vision)领域今天爆出大进展——Meta(前Facebook) AI 研究院发布并开源了他们在 CV 领域的最新研究成果,“分割一切模型”。

图像分割任务不存在了?

分割,识别哪些图像像素属于一个对象,是计算机视觉的核心任务,并被广泛应用于从分析科学图像到编辑照片等一系列应用中。但是,为特定任务创建准确的分割模型通常需要高度专业化的工作,也意味着需要在 AI 基础设施上通过大量经过标注的领域内的数据进行训练。

用眼睛分辨眼前的不同物体容易,用摄像头看可就难了,因为图片对于计算机来说,就是“扁平”的“一坨”。所以,无数的科学家、工程师无时无刻不在研究如何将图片上物体分割开,从而达到“识别”对象的目标。

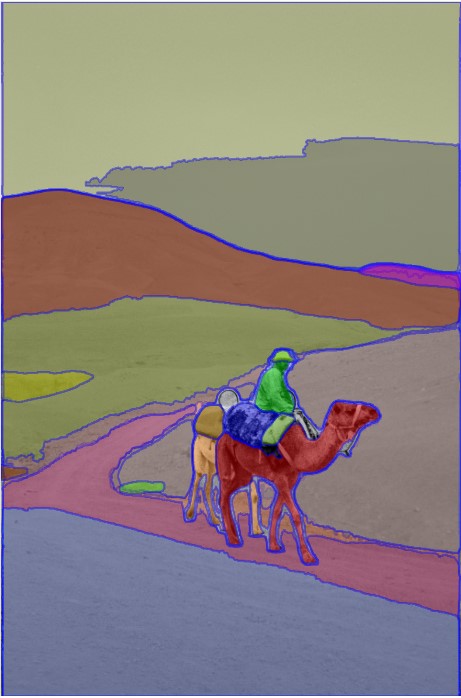

Meta 提出的“分割一切模型”(SAM,Segment Anything Model) 可以根据用户的类似点击、框选的选择动作,从图像上自动产生掩膜(Mask),也就意味着能自动把想分割的图像部分“抠”出来。比如下面这张图就展示了它强大的分割能力。完全自动化的。

最重要的是,这又是一个“大模型”。官方号称这个模型的训练数据集包含 1100 万张图片跟 11 亿个掩膜,从而拥有了对未知分割任务的强大处理能力(zero-shot learning)。 因为通常的图像分割任务,都是从特定领域的数据集训练,再在同样的领域里完成新的任务。

这仿佛是又干掉了一大波儿图像分割研究方向的工作了。

Demo

目前该项目已在 GitHub 开源,地址是 facebookresearch/segment-anything.

同时,官方提供了在线Demo,我试着“抠”了一下,效果不错。

下面这张图片是来自网络的“新”图片,

通过左侧的“Everything”一键分割出所有“零部件”,

惊呆😂

基于此模型的一大波儿创业项目即将来袭~

~~

都看到这儿了,不如关注每日推送的“科文路”、互动起来~

至少点个赞再走吧~

科技:分割一切!AI视觉领域奋起直追